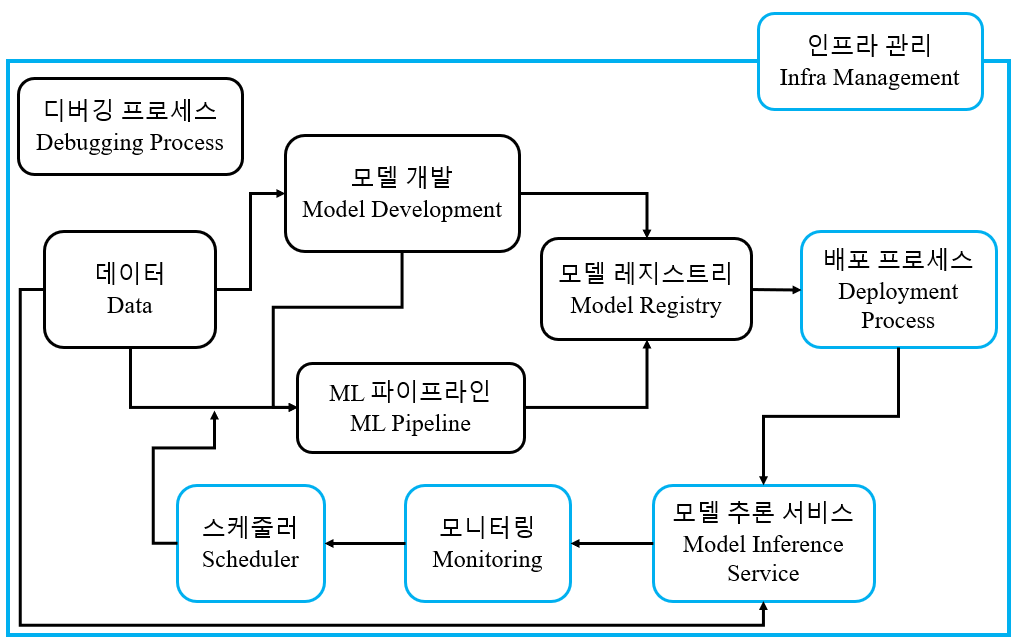

배포 프로세스

- Continuous Deployment

- 프로덕션 테스트 필요, 배포 전략 설정(카나리, Shadow, etc.)

모델 추론 서비스

배포된 모델이 실제로 사용자에게 결과를 추론해주는 서비스

- 서비스 방식 - Online serving(API), Batch serving, Streaming

- 어플리케이션 형태로도 제공 가능

- Pre/Post-processing 로직이 필요한 경우 있음.

- Kserve, Seldon core, TorchServe, Triton inference server, etc.

모니터링

- 프로덕션 테스트 포함(실제 데이터에 대한 성능 분석)

- 데이터 모니터링(Data drift 현상 추적)

- 알람 기능

- Prometheus, Grafana, Elastic, etc.

스케쥴러

특정 조건에 의해 머신러닝 파이프라인을 실행시키는 역할

- Manual / Event(새로운 데이터의 양이 충분하거나, 모델의 성능이 떨어지는 등)-driven / CronJob(특정 시점마다 실행)

- 재활용할 수 있는 파이프라인 실행

- Argo, Linux cron, Airflow, etc.

실행 환경 관리

모델 개발 시점 또는 파이프라인 시점에 모델을 만들었을 때 환경을 저장하여 추론 때 활용

- 패키지 목록, 이미지 등으로 관리

- 개발 환경, Pipeline 실행 환경 , Production 추론 환경을 원활하게 이어주기 위해서 필요

- Docker, Anaconda

디버깅 프로세스

문제가 생겼을 시, 모델, 데이터, 메타데이터로 분석

- 파이프라인 실패 시 사용한 데이터를 개발환경으로 디버깅 환경 제공

- 모니터링 이상 시 model registrty의 모델과 데이터를 개발환경으로 디버깅 환경 제공

- 도구와 프로세스로서 해결해야함.

인프라 관리

- 각 요소에 적절한 자원을 할당하여 정상 작동할 수 있도록 관리(Orchestration)

- Kubernetis, Docker swam, etc.

반응형

반응형

'MLOps > 이론' 카테고리의 다른 글

| MLOps 구성요소(1) (0) | 2024.04.25 |

|---|---|

| MLOps Level 1 : ML pipeline automation (0) | 2024.03.23 |

| MLOps Level 0 (0) | 2024.03.23 |

| Model Decay의 이유(1) : Data Drift, Training-serving Skew (0) | 2024.02.23 |

| 프로덕션 ML 시스템의 특징(Model Decay) (0) | 2024.02.22 |